最强斗地主AI,网易互娱AI Lab提出基于完美信息蒸馏的方法

2022-10-10

网易互娱 AI Lab 联合上海交通大学和 CMU 提出了基于完美信息蒸馏的斗地主 AI--PerfectDou,击败了一众 AI 模型,成为目前的最强斗地主 AI。

近几年随着强化学习技术的发展,游戏 AI 技术已经成功应用在了围棋、德州扑克、星际争霸等不同种类的游戏中。斗地主是非常流行的一种纸牌游戏,它的玩法存在非完美信息 (地主和农民双方均不能看到对方的手牌) 以及策略合作(2 名农民玩家需要通过配合来击败手牌多 3 张的地主),被认为是非常具有挑战性的研究领域。除此以外,游戏本身的出牌组合数较多(27472 种),也极大地限制了如 CFR 等的搜索类算法的使用。

针对上述斗地主游戏的难点,网易互娱 AI Lab 联合上海交通大学和 CMU 提出了基于完美信息蒸馏的斗地主 AI--PerfectDou,击败了一众 AI 模型,成为目前的最强斗地主 AI。相关论文已被 NeurIPS 2022 接收,同时也已经公开了代码以及试玩地址,大家感兴趣可以去和 AI 对战。

论文链接:https://arxiv.org/abs/2203.16406

开源代码地址: https://github.com/Netease-Games-AI-Lab-Guangzhou/PerfectDou

试玩地址:https://outer-perfectdou-demo-gzailab.nie.netease.com

针对斗地主游戏存在的非完美信息、策略合作和动作空间巨大的问题,PerfectDou 主要提出了如下几点贡献:

1. 提出了 PTIE(Perfect-Training-Imperfect-Execution)框架和 node reward 来解决非完美信息问题和策略合作问题

2. 牌类游戏特征的合理建模以及对可行动作的简化来减少模型探索空间,加速 AI 的训练过程

方案介绍

完美信息蒸馏(PTIE)

在斗地主游戏中,非完美信息的引入主要是由于三位玩家均不能看到别人的手牌,对于任意一位玩家而言,仅可知道其余两位玩家当前手牌的并集,而难于精准判断每位玩家当前手牌。完美信息蒸馏的思路是针对这种非完美问题,构建一个第三方角色,该角色可以看到三位玩家的手牌,该角色在不告知每位玩家完美信息的情况下通过信息蒸馏的方式引导玩家打出当前情况下合理的出牌。

以强化学习常用的 Actor-Critic 算法为例,PTIE 在 Actor-Critic 算法的应用中可以利用 Critic 的 Value 输出作为蒸馏手段来提升 Actor 的表现。具体而言即在训练中 Critic 的输入为完美信息(包含所有玩家的手牌信息),Actor 的输入为非完美信息(仅包含自己手牌信息),此种情况下 Critic 给予的 Value 值包含了完美信息,可以更好地帮助 Actor 学习到更好的策略。

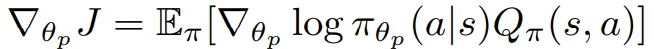

从更新公式上来看,正常的 Actor-Critic 算法 Actor 更新的方式如下:

在 PTIE 模式下,对于每个非完美信息状态 h,我们可以在 Critic 中构建对应的完美信息状态 D(h),并用 Critic 的输出来更新 Actor 的策略梯度,从而达到完美信息蒸馏的效果。

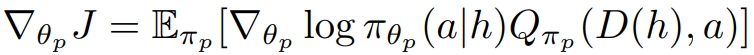

PTIE 框架的整体结构如下图所示:

无论是训练还是执行过程中智能体都不会直接使用完美信息,在训练中通过蒸馏将完美信息用于提升策略,从而帮助智能体达到一个更高的强度。

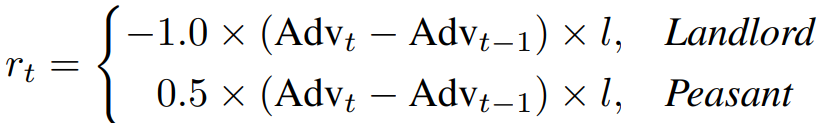

PTIE 的另一种蒸馏方式是将完美信息奖励引入到奖励值函数的训练中,PerfectDou 提出了基于阵营设计的完美信息奖励 node reward,以引导智能体学习到斗地主游戏中的合作策略,其定义如下:

如上所示,完美信息部分

代表 t 时刻地主手牌最少几步可以出完,在斗地主游戏中可以近似理解为是距游戏获胜的距离,

代表 t 时刻地主阵营和农民阵营距游戏获胜的距离之差,

为调节系数。通过此种奖励设计,在训练时既可以一定程度地引入各玩家的手牌信息(出完的步数需要知道具体手牌才能计算),同时也鼓励农民以阵营的角度做出决策,提升农民的合作性。

特征构建:

PerfectDou 针对牌类游戏的特点主要构建了两部分特征:牌局状态特征和动作特征。其中牌局状态特征主要包括当前玩家手牌牌型特征、当前玩家打出的卡牌牌型特征、玩家角色、玩家手牌数目等常用特征,动作特征主要用于刻画当前状态下玩家的所有可能出牌,包括了每种出牌动作的牌型特征、动作的卡牌数目、是否为最大动作等特征。

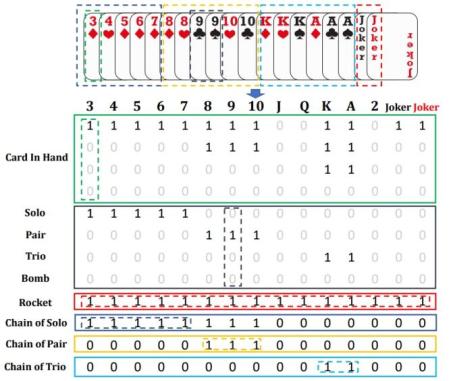

牌型特征为 12 * 15 的矩阵,如下图所示:

该矩阵前 4 行代表对应每种卡牌的张数,5-12 行代表该种卡牌的种类和对应位置。

网络结构和动作空间设计

针对斗地主游戏出牌组合数较多的问题,PerfectDou 基于 RLCard 的工作上对动作空间进行了简化,对占比最大的两个出牌牌型:飞机带翅膀和四带二进行了动作压缩,将整体动作空间由 27472 种缩减到 621 种。

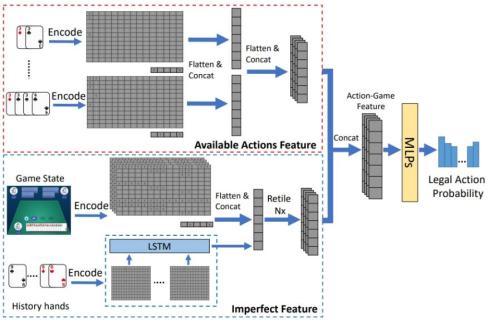

PerfectDou 策略网络结构如下图所示:

策略网络结构同样分为两部分:状态特征部分和动作特征部分。

在状态特征部分,LSTM 网络用于提取玩家的历史行为特征,当前牌局状态特征和提取后的行为特征会再通过多层的 MLP 网络输出当前的状态信息 embedding。

在动作特征部分,每个可行动作同样会经过多层 MLP 网络进行编码,编码后的动作特征会与其对应的状态信息 embedding 经过一层 MLP 网络计算两者间的相似度,并经由 softmax 函数输出对应的动作概率。

实验结果

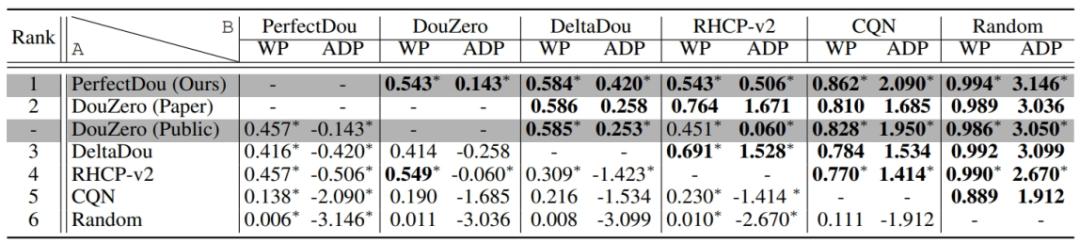

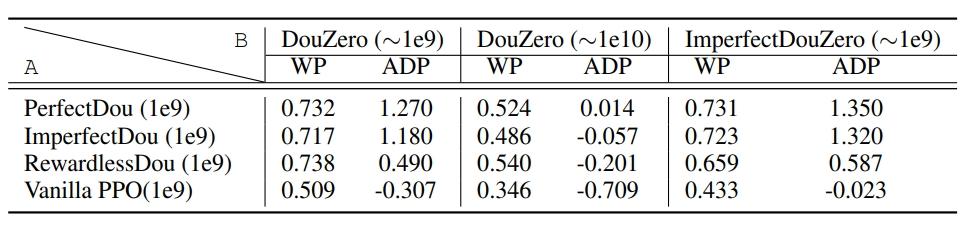

为了验证 PerfectDou 的强度,我们将 PerfectDou 和各个斗地主 AI 分别进行了 1 万局的对战来评估,包括之前的 SOTA 方法 DouZero。主要指标包括两种:WP(胜率)和ADP(场均得分)。其中 ADP 为主要指标,因为其更符合斗地主游戏规则,WP 为辅助指标。

(上表中加粗数字代表 A 对战 B 胜率超过 50% 或者 ADP 大于 0)

从实验结果中可以发现 PerfectDou 能够击败所有的 AI 程序,达到了新的 SOTA 水平。

除此以外PerfectDou还提供了各个核心模块的消融实验结果。

表中的 ImperfectDou、RewardlessDou 是分别去除了 PTIE 和 Node Reward 模块后训练的斗地主 AI,Vanilla PPO 是同时去除两个模块后训练的斗地主 AI,ImperfectDouZero 是尝试使用 PerfectDou 设计的特征和 DouZero 方法进行训练的斗地主 AI。通过上表我们可以发现 PerfectDou 的强度提升还是得益于 PTIE 和 Node Reward,并且两部分均发挥了不可获缺的作用。这也进一步验证了论文主要贡献点的有效性。